偏见是真实的:人力资源AI偏见及其解决方法

随着人工智能(AI)在不同领域的兴起,关于偏见可能性的问题也越来越多。人工智能引擎并不具备与人类决策者相同的识别能力。因此,当曲解的数据被输入到一个算法中时,人工智能就有可能产生偏差。

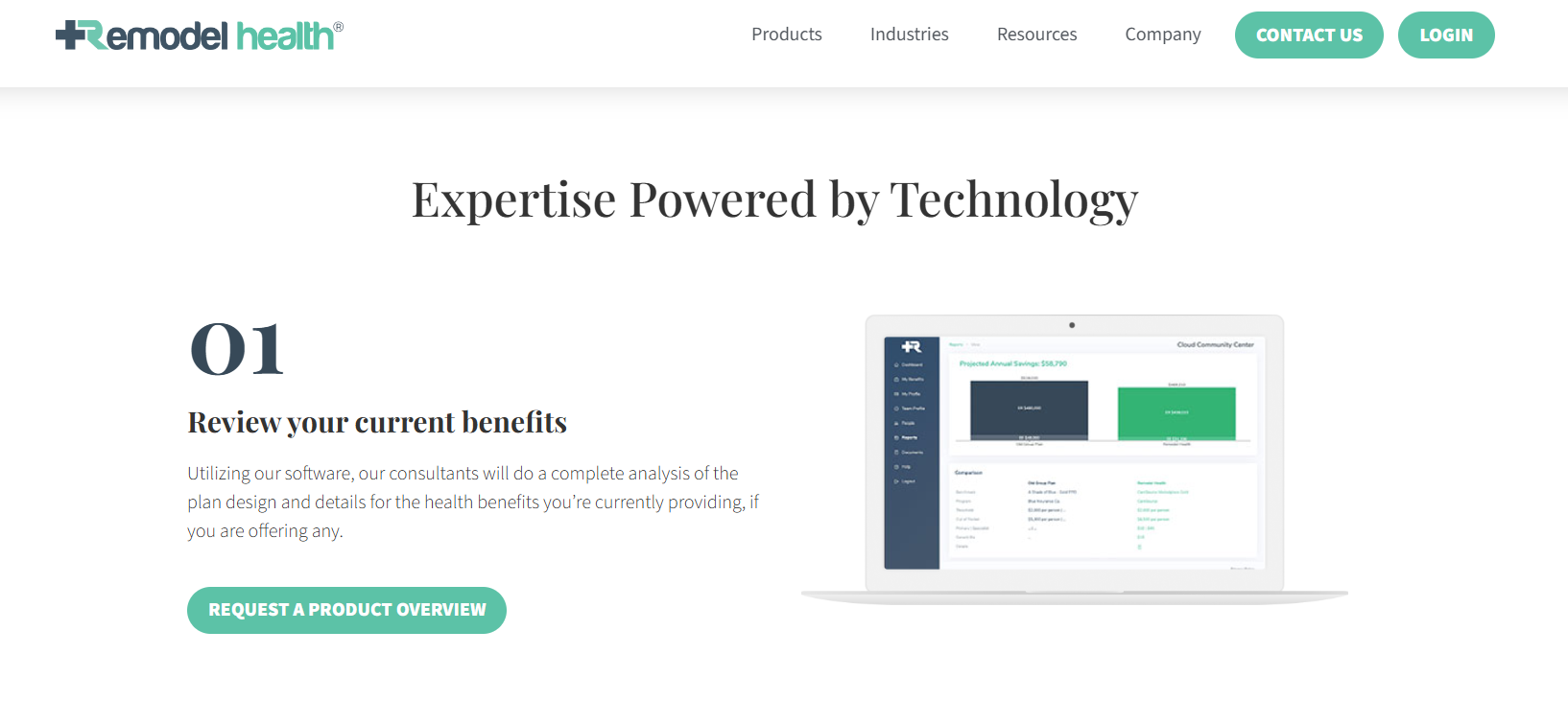

例如,英国特许保险协会(CII)最近的一份报告发现,用于训练AI算法的数据集中普遍存在性别偏见。这也适用于其他行业。那么,企业如何才能解决人力资源中的AI偏见问题,并在道德上利用该技术的巨大潜力来改善人力资源系统呢?五位领先的专家分享了他们的见解。

检查AI偏差时要记住的五件事

有趣的是,创建AI引擎并非出于偏见。但是,如果使用有偏见的数据集进行训练,他们很可能会产生偏见。同样,开发人员直到AI引擎开始产生结果后才可能注意到。

例如,如果不断向自动化招聘人员提供数据,表明男性更适合担任技术职务,或者女性更适合需要更多软技能的工作,那么AI招聘工具将使这种偏

扫一扫 加微信

hrtechchina

扫一扫 加微信

hrtechchina